视频 | “大模型热”拉动算力需求 火山引擎宣布与字节国内业务“并池”

华龙网-新重庆客户端讯(首席记者 董进 宋卫)AI大模型技术应用爆发,云市场也在加速变革。4月18日,火山引擎在“原动力大会”上宣布,与字节跳动国内业务并池。

基于内外统一的云原生基础架构,抖音等业务的空闲计算资源可极速调度给火山引擎客户使用,离线业务资源分钟级调度10万核CPU,在线业务资源也可潮汐复用,弹性计算抢占式实例的价格最高可优惠80%以上。

让大模型训练快速跑起来

自2022年底发布以来,ChatGPT成为人类历史上最快获得上亿用户的消费级互联网应用。最新的GPT-4大模型,更是在法律、数学、生物学等多项测试中超过90%人类。

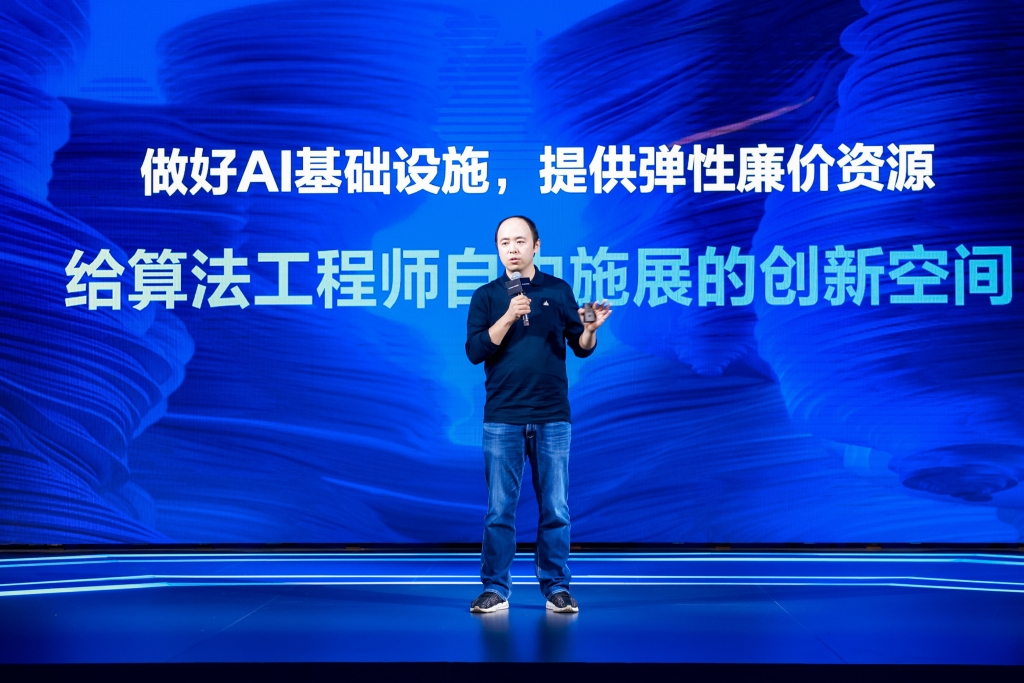

火山引擎总裁谭待表示,国内很多科技公司投入到大模型建设中,他们有优秀的技术团队,也有丰富的行业知识和创新想法,但往往缺乏经过大规模场景实践的系统工程能力。火山引擎要做的,就是为大模型客户提供高稳定性和高性价比的AI基础设施。

据悉,火山引擎机器学习平台经过抖音等海量用户业务长期打磨,支持单任务万卡级别的超大规模分布式并行训练场景。GPU弹性计算实例可灵活调度资源,随用随取,最高可以为客户节省70%的算力成本。

字节跳动副总裁杨震原认为,业务创新需要试错,试错要大胆、敏捷,但试错也一定要控制成本。通过潮汐、混部等方式,火山引擎实现资源的高利用率和极低成本。

以抖音推荐系统为例,工程师用15个月的样本训练某个模型,5小时就能完成训练,成本只有5000元。火爆全网的抖音“AI绘画”特效,从启动到上线只用一周多时间,模型由一名算法工程师完成训练。

向“多云多模型”架构演进

有评论称,大模型将成为云厂商弯道超车的机会。谭待对此表示,大模型还在发展初期,面临数据安全、内容安全、隐私保护、版权保护等许多问题需要努力解决。但可以预见,大模型将带动云上AI算力急剧增长,AI算力的工作负载与通用算力的差距会越来越小,这会为各家云厂商带来新的机会,同时也会对数据中心、软硬件栈、PaaS平台带来新的挑战。

在此次原动力大会上,火山引擎发布了新一代自研DPU,实现计算、存储、网络的全组件卸载,释放更多资源给业务负载。

此外,自动驾驶公司毫末智行与火山引擎合作打造智算中心,为DriveGPT自动驾驶生成式预训练模型提供强大的算力支持。毫末智行CEO顾维灏介绍,DriveGPT使用量产车4000万公里的人驾数据训练,参数规模达1200亿,对自动驾驶认知决策模型进行持续优化。

杨震原表示,火山引擎对内对外提供统一的产品,抖音、今日头条等APP开屏都加上了“火山引擎提供计算服务”。杨震原说:“数字化时代,机器学习可以智能、高效地围绕目标解决问题。数字化的下一步是智能化,我们在机器学习方面的技术积累和经验,都会通过火山引擎提供给外部客户,帮助更多企业做好智能化”。

无障碍

无障碍

亲爱的用户,“重庆”客户端现已正式改版升级为“新重庆”客户端。为不影响后续使用,请扫描上方二维码,及时下载新版本。更优质的内容,更便捷的体验,我们在“新重庆”等你!

亲爱的用户,“重庆”客户端现已正式改版升级为“新重庆”客户端。为不影响后续使用,请扫描上方二维码,及时下载新版本。更优质的内容,更便捷的体验,我们在“新重庆”等你!